iOS 13.2 的杀手锏 —— Deep Fusion

近几年兴起的深度学习技术让计算机处理图形图像的能力直线提升了一个档次,而近一两年,随着 AI 这个概念在行业内的热度越来越高,厂商在这一领域内不断加大研发方面的投入,AI 专用的硬件应运而生。

目前在手机 SoC 里很常见的 NPU 就是一种专为 AI 计算而生的独特芯片,它功耗很低,但是可以在 AI 计算方面起到一个非常好的加速作用。NPU 的存在让小到如手机这样的设备也能够轻松运行起一些相对比较复杂的 AI 程序,它为整部手机提供了一个很强大的算力支撑。

有了基础设施,上层建筑也就可以搭起来了。手机厂商们开始发力用深度学习技术来对相机进行优化,早期深度学习技术更多是被用在美颜这一方面,后续深度学习技术才更多地被用于对场景做识别、针对不同场景自动通过不同的参数对成像进行优化。

例如夜景的拍摄,很多 Android 阵营的手机就利用了深度学习技术做了所谓的「AI 夜景」,通过算法对硬件直出的图像进行后期处理以提升成像的效果。

作为行业的老大哥,在利用深度学习技术对相机做功能增强、优化这一方面,苹果相较于 Android 手机厂商来说反而是要保守很多。

iPhone 的相机一直以来都更致力于拍摄出一个偏向于「真实」的照片,避免对照片进行过度的后期处理,使照片尽可能地保留「原汁原味」,也为一些专业人士对 iPhone 拍出的照片进行进一步的处理留下一定空间。

然而,既然芯片有这么强的算力,而且深度学习对于图形图像处理来说确实是一把尚方宝剑,利用它也确实可以让 iPhone 的成像效果有一个质的提升。但受限于苹果一直以来在 iPhone 相机上坚持的这个「还原真实」的理念,苹果又不能像国内 Android 厂商那样在相机这一方面直接怼上一大堆所谓的「AI 算法」,呈现一个很悦眼但是可能有一定程度失真的照片。

所以在相机这一方面,苹果对深度学习技术的利用一直以来都比较克制。到 iPhone 11 这一代产品,苹果做过宣传的、凭借芯片强大算力利用深度学习技术对照片进行增强的功能只有四个。

利用 iPhone X 产品配备的深度传感器,苹果推出了 Portrait Lighting 功能,也就是国内手机厂商后续模仿时所称的「AI 影棚光效」,它能够对照片进行非常强大的后期处理,呈现一个影棚级别的光影效果。

这是苹果将深度学习技术第一次用在 iPhone 的相机上,这一项功能并不影响 iPhone 相机本身的成像,它只是一个可选的后期处理。

值得一提的是,在 iPhone 11 上,得益于三摄模组,iPhone 能够对物体进行一个大致的测距,因而这一功能已经不只适用于自拍,它还扩展到了对物体的拍摄上。

在 iPhone X 的这一次尝试之后,苹果在 iPhone Xs 这一代产品上更加大胆地加入了 Smart HDR 功能,这个功能与 iPhone 成像的效果直接相关。

启用 Smart HDR 功能后,iPhone 会对场景进行自动的识别,基于识别出来的场景,iPhone 会使用不同的曝光度抓拍多张照片,之后系统会利用深度学习算法对这多张照片取细节最优的部分进行合成,得到一张总体细节有显著增强的照片。

Smart HDR 这个功能其实和目前国产手机对相机成像做的优化是比较类似的,但是得益于苹果优秀的调校,最终的照片仍然还是趋近于真实的,照片的味道还是一如既往的淡,不会像一些厂商一样用鲜艳的色彩等来刻意讨好用户的眼球,让用户感觉拍出来的照片有一个很好的效果。

在这个功能刚刚推出的时候,欧美用户对这个功能的反响不是特别好,主要是因为苹果将 Smart HDR 一并用在了自拍上,导致自拍得到的照片会呈现出一个不怎么真实的照片,看起来像是被美颜了一样。欧美用户并不喜欢这种被强行 P 好看了的自我欺骗的感觉,他们希望 iPhone 能够呈现出自己更加真实的相貌,于是苹果在 iOS 的后续版本中对这个点做了一些修补。

这两个功能在笔者看来都不怎么重磅,因为它们虽然利用到了深度学习技术,但是前者只是一个可选的后期效果,在日常的拍照中很少会用到,而后者则只是一个很常见的利用深度学习技术来对相机成像做的优化罢了,提升存在,但是横向对比没有突出的地方。

而在 iPhone 11 上,由于 A13 在 AI 方面的算力上又向上增长了一截,苹果选择不再克制深度学习技术在 iPhone 相机上的应用。

这一次苹果在 iPhone 11 系列的相机上加入的最具重量级的两个新功能都是一个完全基于深度学习技术打造出来的功能,一个是 Deep Fusion,一个是夜间模式。

夜间模式已经实装到了 iOS 中,对于 iPhone 来说,它确实对夜拍带来了很大的提升,在光线很暗的环境下 iPhone 的拍照再也不是「残疾」,但是和华为手机的夜拍相比,iPhone 这个更多靠软件进行提升的方案还是明显要更弱一些。

在 iPhone 11 上,真正的杀手锏是 Deep Fusion,这是苹果今年为了在拍照上力压 Google 的 Pixel 打出的一张最狠的牌。

直至目前正式推出的 iOS 13.1,这一在发布会上预热过的功能还没有正式加入到 iOS 中,但是在向开发者推送的 iOS 13.2 上,Deep Fusion 已经实装到了系统中。

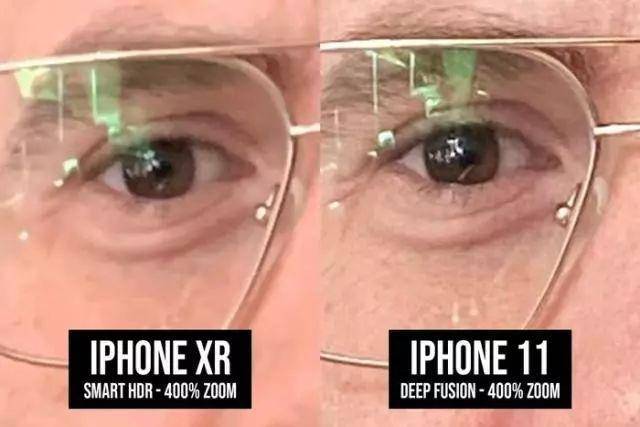

Deep Fusion 是利用强大 AI 算力对 iPhone 拍摄出来的画面进行细节增强的功能,这一代 iPhone 使用的摄像头仍然只是 1200 万像素,而国产 Android 旗舰很多已经达到了 4000 万像素、4800 万像素、6400 万像素甚至是超一亿像素,在解析力上,iPhone 11 的相机已经根本没有办法去和 Android 阵营的这些旗舰进行 PK。

相机硬件先天不足,导致出来的照片细节不够,怎么办。

苹果想了一个非常妙的招数,硬件不够,AI 来凑,苹果希望通过 Deep Fusion 在像素只有 1200 万的摄像头上得到细节清晰度更高一个档次的照片。这个对细节的增强可不仅仅只是锐化等这么简单,即使用户放大照片数倍,用户看到的照片细节仍然是真实且清晰的,看起来根本就不像是由一颗 1200 万像素摄像头拍出来的。

网友起初猜测 Deep Fusion 可能和华为的拍月亮一样,是一个高级的、利用 AI 来修图、P 图的功能,这个细节是 AI 自动脑补上去的,并非是真实拍摄出来的。

然而实际上,苹果走的并不是这一条路,AI 并不会自动去脑补出画面的细节填在画面上,而且即使 A13 的算力很强悍,目前市面上也没有一个容量足够迷你的、神经网络足够精简的模型来应付现实世界中如此多变的场景。

Deep Fusion 原则上仍然是一个多帧合成,只不过这个多帧合成和我们原先认知中的多帧合成有一些不太一样。

在用户按下快门之前,iPhone 就会对场景进行不断地拍摄,当用户准备拍摄的时候,iPhone 实际上就会预先采集当前场景中的 8 帧场景,其中有 4 帧是长曝光,4 帧是短曝光。至于苹果是怎么做到在用户拍摄之前就采集照片的,这实际上和「实况照片」是一个道理。

这 8 帧图像并不会经过 ISP 的处理,而是直接送到 A13 的神经网络模块中直接进深度神经网络模型进行处理。在 Deep Fusion 这个功能上,苹果采用了一个和 Smart HDR 完全不同的模型,这个模型会对长短曝光的照片进行「像素级别」的分析与比对,逐一处理照片中的每个像素,对图像进行细节增强。

在用户按下快门的时候,这一瞬间 iPhone 捕捉到的一张长曝照片也会参与到照片的后期融合中。在如此大量的输入数据中,Deep Fusion 会选择这一批数据中细节最深刻、光影细节最饱满的像素放到最终的输出结果中,使得我们最终看到的照片是噪音非常低、细节非常饱满且深刻的。

你所看到的照片仍然是由你的设备正式拍摄出来的照片,Deep Fusion 并不会对它进行一些什么额外的处理,照片仍然具有那种原汁原味的真实感。不论是拍摄人像,还是拍摄一些物件(例如毛衣这种针织织物),Deep Fusion 永远可以给你呈现出一个十分饱满且清晰的细节,因为是逐像素进行处理,而且细节并非是 AI 自行脑补,所以即使将照片放大很多倍,你仍然能够看到足够自然、真实且清晰的细节。

不得不说,在 Deep Fusion 上,苹果对深度学习技术的运用真的是非常巧妙,苹果一方面遵循了他们做 iPhone 相机的理念,一方面又让 iPhone 的成像效果得到了一个非常显著的提升,在这一级别的硬件下,能够实现这样的效果已经相当不错了。

值得一提的是,并不是所有用户都喜欢有这样一个 AI 来帮自己处理图片,所以苹果允许用户在系统设置中关闭相关的选项来禁用掉这些后期处理方面的功能。

由于 Deep Fusion 需要采集更多的数据来进行后期处理,所以每一张应用了 Deep Fusion 的照片在体积上相较于普通的照片以及开启了 Smart HDR 的照片都会更大一些。如果你使用的是存储容量较小的 iPhone 11,那么你可能需要订阅一个更大的 iCloud 的空间。

笔者在看到 Deep Fusion 的第一眼就在想,实际上高通、海思麒麟 SoC 内置的 NPU 算力也不低,尤其是麒麟 990 这一批搭载了华为自研达芬奇架构 NPU 的 SoC,其算力很有可能要比 A13 还要更强大一些。

如果国内这一批本身算力就不低、拍照硬件本身就不差的设备,也可能够和 iPhone 一样做一个类似的细节增强算法,其成像效果必然还能够向上抬一个档次,突破原有的天花板。

然而很可惜的是,国内的手机厂商在相机上做的这些功能点不论是在功能的性质上还是在参数的调校上更多还是倾向于讨好用户的眼球,将照片调成一个很悦眼的状态来让用户感觉良好,甚至是用「P 图」等方式来欺骗用户。

厂商们应该和苹果一样去从一些更加基本的角度对深度学习在相机成像优化上的应用进行思考,一个多帧合成在苹果手上已经衍生出了两个重磅的功能,然而在国内 Android 厂商的手上,除了烂大街的超级夜景和一些常规的优化外,具有很大创新性、能够显著提升照片质量的功能很少很少,利用供应商现成方案或是跟风模仿的倒是非常多。

iPhone 可能在不少方面已经落后了 Android 阵营,但是在软件的探索上,至少目前来看,苹果仍然还是行业内的领先者。

技宅空格

技宅空格